„Microsoft“ šiandien pareiškė, kad išleido „pajėgiausius ir ekonomiškiausius mažų kalbų modelius (SLM)“, sakydama, kad „Phi-3“ – trečioji „Phi“ mažų kalbų modelių (SLM) šeimos iteracija – pranoksta panašaus dydžio modelius ir keletas didesnių.

Mažos kalbos modelis (SLM) yra AI modelio tipas, sukurtas taip, kad būtų itin efektyvus atliekant konkrečias su kalba susijusias užduotis. Skirtingai nuo didelių kalbų modelių (LLM), kurie puikiai tinka daugeliui bendrųjų užduočių, SLM yra sukurti naudojant mažesnį duomenų rinkinį, kad būtų veiksmingesni ir ekonomiškesni tam tikrais naudojimo atvejais.

„Phi-3“ yra įvairių versijų, paaiškino „Microsoft“, o mažiausia yra „Phi-3 Mini“, 3.8 milijardo parametrų modelis, parengtas naudojant 3.3 trilijono žetonų. Nepaisant palyginti mažo dydžio – „Llama-3“ korpusas sveria daugiau nei 15 trilijonų duomenų, „Phi-3 Mini“ vis tiek gali apdoroti 128 4 konteksto žetonų. Tai leidžia jį palyginti su GPT-3 ir lenkia Llama-XNUMX bei Mistral Large pagal žetonų talpą.

Kitaip tariant, dirbtinio intelekto begemotai, tokie kaip „Llama-3“, esantys „Meta.ai“ ir „Mistral Large“, gali sugriūti po ilgo pokalbio arba paraginti gerokai anksčiau, nei šis lengvas modelis pradės vargti.

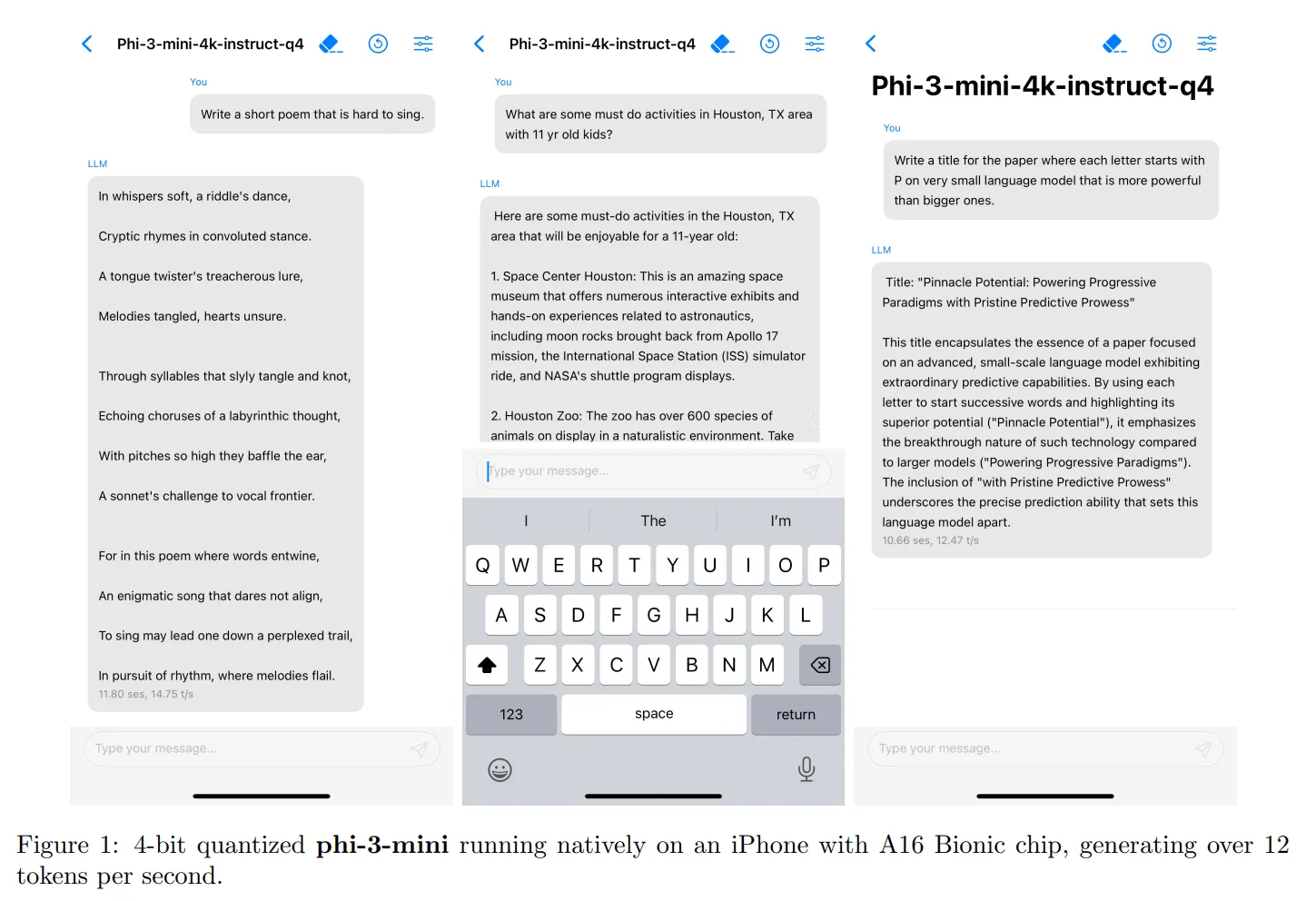

Vienas iš svarbiausių „Phi-3 Mini“ pranašumų yra jo galimybė tilpti ir veikti su įprastu išmaniuoju telefonu. „Microsoft“ išbandė modelį „iPhone 14“ ir veikė be problemų, generuodamas 14 žetonų per sekundę. „Phi-3 Mini“ paleidimui reikia tik 1.8 GB VRAM, todėl tai lengva ir efektyvi alternatyva vartotojams, turintiems tikslesnius reikalavimus.

Nors „Phi-3 Mini“ gali būti netinkamas aukščiausios klasės programuotojams ar žmonėms, turintiems didelių reikalavimų, jis gali būti veiksminga alternatyva specifinių poreikių turintiems vartotojams. Pavyzdžiui, pradedančios įmonės, kurioms reikalingas pokalbių robotas, arba žmonės, naudojantys LLM duomenų analizei, gali naudoti „Phi-3 Mini“ tokioms užduotims kaip duomenų tvarkymas, informacijos išgavimas, matematiniai samprotavimai ir agentų kūrimas. Jei modeliui bus suteikta prieiga prie interneto, jis gali tapti gana galingas, o galimybių trūkumą kompensuoti realiuoju laiku pateikiama informacija.

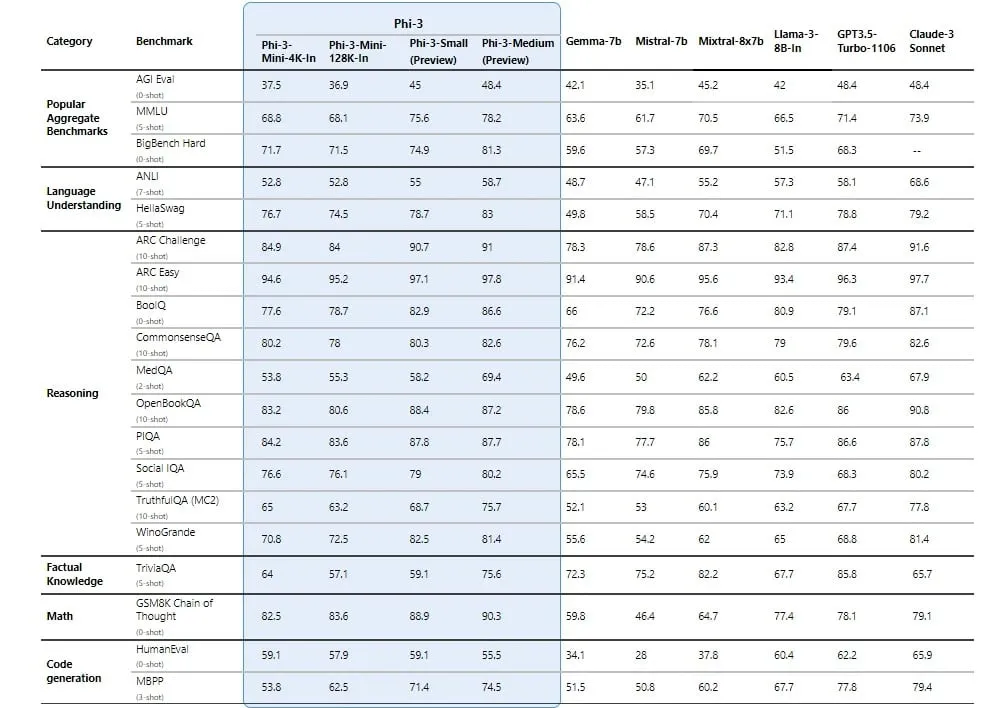

„Phi-3 Mini“ pasiekia aukštus testo balus, nes „Microsoft“ sutelkia dėmesį į duomenų rinkinio kuravimą naudojant kuo naudingesnę informaciją. Tiesą sakant, platesnė Phi šeima nėra tinkama užduotims, kurioms reikia faktinių žinių, tačiau aukšti samprotavimo įgūdžiai iškelia juos aukščiau pagrindinių konkurentų. „Phi-3 Medium“ (14 milijardų parametrų modelis) nuosekliai lenkia tokius galingus LLM kaip GPT-3.5 – LLM, maitinantį nemokamą „ChatGPT“ versiją, o „Mini“ versija daugumoje sintetinių etalonų lenkia tokius galingus modelius kaip Mixtral-8x7B.

Tačiau verta paminėti, kad „Phi-3“ nėra atvirojo kodo, kaip ir jo pirmtakas „Phi-2“. Vietoj to, tai yra atviras modelis, tai reiškia, kad ji yra prieinama ir prieinama naudoti, tačiau ji neturi tos pačios atvirojo kodo licencijos kaip Phi-2, kuri leidžia plačiau naudoti ir naudoti komercines programas.

Artimiausiomis savaitėmis „Microsoft“ pranešė, kad išleis daugiau „Phi-3“ šeimos modelių, įskaitant „Phi-3 Small“ (7 mlrd. parametrų) ir minėtą „Phi-3 Medium“.

„Microsoft“ padarė „Phi-3 Mini“ prieinamą „Azure AI Studio“, „Hugging Face“ ir „Ollama“. Modelis suderintas su instrukcijomis ir optimizuotas „ONNX Runtime“ su „Windows DirectML“ palaikymu, taip pat kelių platformų palaikymu įvairiose GPU, procesoriaus ir net mobiliosios aparatinės įrangos srityse.

Sekite kriptovaliutų naujienas, gaukite kasdienius atnaujinimus savo pašto dėžutėje.

Šaltinis: https://decrypt.co/227974/microsoft-phi-3-mini-small-ai-language-model